Microsoft a récemment annoncé le lancement de « Correction », un nouvel outil conçu pour rectifier les erreurs les plus surprenantes générées par les IA. Cette initiative vise à renforcer la sécurité et la fiabilité des intelligences artificielles, une démarche essentielle dans un domaine où les réponses erronées peuvent avoir des conséquences imprévues.

Microsoft »Correction » : un outil pour rendre l’IA plus fiable malgré ses limites

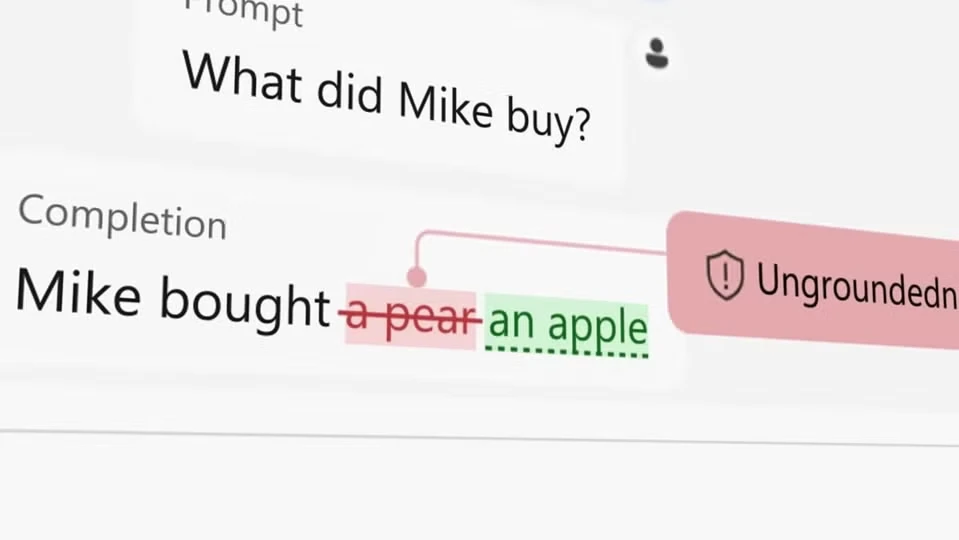

Dans un billet de blog, Microsoft souligne son ambition de promouvoir une IA « digne de confiance », en axant ses efforts sur la sécurité, la confidentialité et la fiabilité. L’outil « Correction » a ainsi été développé pour corriger en temps réel les anomalies ou erreurs grossières que peut produire une IA lors de la génération de réponses. Il permet de fournir à l’utilisateur une version corrigée de la réponse initiale.

Cependant, Windows Central rapporte les préoccupations de certains experts qui estiment qu’éliminer complètement ces erreurs est une tâche complexe, voire impossible. Comme l’explique OS Keyes, doctorant à l’Université de Washington : « Essayer d’éliminer les hallucinations de l’IA générative, c’est comme essayer d’éliminer l’hydrogène de l’eau. C’est un élément essentiel du fonctionnement de la technologie. » En effet, ces erreurs, parfois absurdes, rappellent que les réponses fournies par les IA ne doivent pas toujours être prises au pied de la lettre. L’imperfection de l’IA pourrait même jouer un rôle crucial en incitant les utilisateurs à faire preuve d’esprit critique face aux informations générées.

Optimisation des IA comme ChatGPT et Llama pour réduire les erreurs

L’outil « Correction » fait partie de l’API Azure AI Content Safety de Microsoft et peut être intégré à plusieurs modèles d’IA générative de texte. Par exemple, Llama de Meta ou ChatGPT d’OpenAI, selon Windows Central. Un porte-parole de Microsoft a précisé que cet outil est adapté aux modèles de différentes tailles, mais qu’il prend toute sa pertinence avec les grands modèles de langage. Ces derniers sont capables de traiter d’énormes quantités de données, parfois au point de générer des réponses incohérentes en raison de l’étendue des informations qu’ils tentent de croiser.

Bien que les erreurs des IA puissent sembler problématiques, elles pourraient aussi servir de levier. Ceci, pour encourager les utilisateurs à adopter une approche plus critique vis-à-vis des informations générées par ces technologies.

Laisser un commentaire